|

"L'acte de penser et l'objet de la pensée se confondent" Parménide Full Screen | Play Le contenu de ce wiki est Copyleft

|

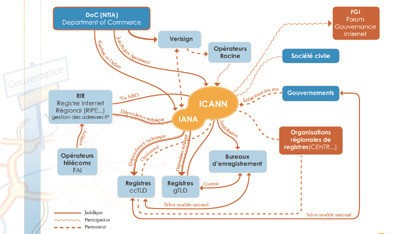

Contribution aux " Assises du numérique" et à la Semaine de l'Internet Mondial de Paris (22 au 28 juin 2008)

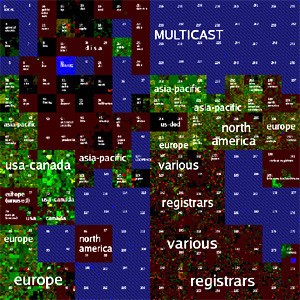

Version PDF imprimable Article aussi disponible sur: Yahoo! AgoraVox Blog de la P2P foundation Blog de l'Hyper-république Blog du mouvement de refondation de l'ISOC Voir aussi le résumé de la conférence d'OlivierAuber donnée dans le cadre des "entretiens du nouveau monde industriel" (Cap Digital, IRI, Centre Georges Pompidou), 4 oct. 2008. GAME OVER Changeons l'Internet! Par Olivier Auber, Olivier Zablocki (Ψ.observers) Si pour nous, utilisateurs de base de l'Internet, la gouvernance du réseau ressemble à une collusion entre acteurs techniques, commerciaux et politiques [1] , c'est que contrairement à l'opinion couramment admise selon laquelle l'Internet serait un organisme acentré fonctionnant de manière répartie, il est au contraire parfaitement centralisé [2]. Le réseau est organisé de manière hiérarchique au niveau de ses normes et de son infrastructure. Au sommet de la pyramide il y a les 13 grands registres d’adresses dites « racines DNS » qui ne forment en fait qu’une seule et même entité au coeur de laquelle se situe le fichier IANA des racines d'adressage qui conditionnent la topologie du réseau [3].  Carte de la gouvernance de l’Internet établie par l’AFNIC (Association française pour le nommage Internet en coopération) L'ICANN (Internet Corporation for Assigned Names and Numbers) assure l'intégrité de l'édifice au nom de l'intérêt général et des utilisateurs censés être au centre de tout. Dans les faits, ces utilisateurs ne sont jamais réellement partie prenante des discussions. Les grands groupes industriels et les Etats (autres que les Etats-Unis) font comme s'ils avaient voix au chapitre, mais c'est une illusion! En simplifiant à peine, à l'échelle mondiale, c'est le Département de la Défense américain et celui du Commerce qui ont le doigt sur le bouton ON/OFF du réseau, via des instances qu'ils contrôlent plus ou moins directement et divers avatars commerciaux, tels Google qui n'en finit pas de rafler toutes les données mondiales en même temps qu'une part toujours plus grande des cerveaux, des capitaux et des recettes publicitaires. S'il en est ainsi, ce n'est pas le fait d'un quelconque complot. C'est la conséquence de l'architecture historique de l’Internet qui dès sa création a dessiné un monde où l'Europe et le reste du monde avaient déjà perdu. Les organes centraux américains ont toujours pris logiquement les décisions qu'il fallait pour renforcer leur position dominante et toutes les structures intermédiaires n'ont jamais rien fait d'autre que de se disputer les miettes (marchés locaux). Trente ans après sa création, le "réseau des réseaux" a produit des concentrations capitalistiques sans précédent, cristallisées dans des infrastructures (backbones et serveurs DNS), des normes (protocoles d'échange, etc.), des codes (logiciels) et pour finir dans une langue dominante (l'anglais). La situation de monopole est le rêve du capitalisme, jusqu'à un certain point. Aujourd’hui, le grand méchant loup, voyant qu’il a dévoré tous les agneaux, commence à s'apercevoir qu’ils n’aura bientôt plus rien à se mettre sous la dent. Surtout les petits prédateurs locaux voient qu'ils se retrouveront bientôt sans proies. Si rien ne change, le capitalisme se sera tiré une balle dans le pied: GAME OVER. Dans ce contexte de domination absolue, quelles chances a encore une quelconque pluralité linguistique et culturelle de s'imposer? A notre avis aucune, si on se contente de jouer suivant les règles du jeu actuelles. Les organismes internationaux qui portent ce type de revendications sont intrinsèquement divisés, en proie à des conflits de légitimité sans fin. Ils ont recours en dernier ressort aux Etats dont les modalités démocratiques sont disparates, sujettes à caution, et archaïques en regard des usages de l'Internet. Après le 11 septembre 2001, les Etats sont devenus les principaux artisans du "tout sécuritaire" qui entraîne lui-même la défiance et le terrorisme que leur sécurité prétend combattre... La maigre souveraineté qu'ils tentent d'obtenir sur des zones linguistiques, géographiques et culturelles du réseau n'apparaît pas aux simples utilisateurs que nous sommes comme une planche de salut. Bien au contraire, nous la vivons comme un niveau de verrouillage supplémentaire reproduisant à une échelle plus réduite celui qui est à l'oeuvre à l'échelle mondiale. Le cas de la Chine est l'emblème de cette dérive, mais les pays européens ne sont pas en reste (pénalisation du P2P, généralisation de la surveillance du réseau via les serveurs DNS locaux, etc.). Ils n'apparaissent en rien comme des barrières au contrôle et à l'uniformisation des esprits. Pire, ils agissent en défenseurs des lobbies et en représentants de commerce de "l'Internet haut débit". Mais nous ne voulons pas de cet Internet là qui livre les citoyens pieds et poings liés à des grands groupes! Bref, sur le plan linguistique et culturel aussi, nous sommes au bord de la déréliction complète. GAME OVER. Entendons-nous bien: il ne s'agit pas de faire ici le procès des personnes impliquées dans les organismes cités plus haut, ni même de mettre en doute leur engagement et leur sincérité. Nous constatons simplement qu'ils fabriquent collectivement et à grand frais un monde dans lequel chacun d'entre eux, à titre individuel, ne désire même pas vivre. Tous sont finalement des victimes d'un phénomène systémique, à la racine duquel se trouve selon nous l'architecture actuelle de l'Internet héritée d'une conception ancienne et dépassée de la cybernétique [5]. Alors où est la sortie? Et bien peut-être dans l'exploration d'une nouvelle architecture du réseau. Il est dit partout que la version actuelle du protocole sur lequel fonctionne l'Internet depuis 25 ans arrivera à saturation vers 2011 et qu'en conséquence le passage à sa version 6 (IPv6) devra avoir lieu avant, c'est-à-dire tout de suite [6]. Beaucoup n' y voient qu'un un saut quantitatif, à savoir que les nouvelles adresses disponibles à profusion (2 puissance 128, soit environ 2,56 × 10 puissance 38) pourront être utilisées pour identifier, relier et contrôler n'importe quoi (qui), ce qui peut être la source de nouveaux profits ; jusque là, rien de nouveau sur le fond. Mais il y a dans IPv6 l'amorce d'un changement qualitatif qui, selon nous, a une importance décisive: c'est la notion d'adressage de groupe connue sous le nom de "IP Multicast" définie par Steve Deering [7] dès 1985. Dans l’Internet tel que nous le connaissons, il est impossible de réunir un « groupe » - ce terme désignant une assemblée en conversation synchrone ou asynchrone comprenant plus de deux personnes, ce qui peut vouloir dire des millions - sans avoir recourt à une machine particulière effectuant la commutation entre les individus. Cette machine dépend nécessairement d’un tiers extérieur au groupe (Facebook par exemple), c'est à dire que l'on est toujours "chez quelqu'un" lorsque l'on croit être dans une simple conversation avec autrui dans l'espace public. Il faut donc le dire et le répéter : à ce jour, il n'existe pas de véritable espace public sur l'Internet ! Dans le contexte de verrouillage commercial et sécuritaire du réseau auquel nous assistons, cela équivaut de plus en plus à une « interdiction de réunion sur la voie publique » puisque cette voie publique n'existe pas, en tous cas à une surveillance automatique des réunions privées. Les « adresses de groupe » prévues dans la prochaine version de l’Internet font potentiellement sauter ce verrou. Elles ne sont pas attachées à une machine particulière. A ce jour, elles ne sont pas la propriété de qui que ce soit, et peuvent être choisies et utilisées par n’importe qui. Tel que défini par Steve Deering, le protocole Multicast est symétrique, c'est à dire qu'il est théoriquement possible pour tous de recevoir ET d'émettre un flux de quelque nature que ce soit sous couvert d'un numéro de groupe. Bien entendu, il faut pour cela des logiciels particuliers [8] capables de formater et d'interpréter ces données. Dès lors, il est possible avec le Multicast de faire de manière économique et sans dépendre de tiers, beaucoup de choses que l'ont fait déjà avec l'Internet actuel (dit Unicast), mais il est surtout envisageable de concevoir une toute nouvelle classe d'applications collaboratives distribuées qui pourraient rendre désuètes très rapidement celles du Web 2.0. Il y a donc en germe dans IPv6 une toute nouvelle culture du réseau, voire un changement de paradigme qui pourrait remettre le compteur à zéro, à tout le moins rebattre les cartes entre les Etats-Unis et le reste du monde. Ipv6 peut contribuer à créer enfin un véritable espace public sur l'Internet, à condition que cette idée soit défendue.  Map of the Internet Address Space, LANDER Project (Los Angeles Network Data Exchange and Repository) - [[http://www.isi.edu/ant/address/browse/index.html (plein écran) Ce changement, nous l’analysons comme le passage d’un réseau fonctionnant suivant une forme de « perspective temporelle » admettant comme points de fuite les serveurs assurant la commutation des groupes, à un autre où s’exercerait une « perspective numérique » [9] régulée par des « codes de fuite » que sont les adresses IP de groupe. Cette transformation extrêmement profonde pourraient conduire l'actuelle "économie de l'attention" a muter en une "économie du lien" impliquant de tout autres rapports sociaux. Elle induit au passage un renouveau complet des formes de légitimité des structures présidant aux destinées du réseau. Dans un esprit plus proche de la « seconde cybernétique » [10], ces organismes devront s’inclure eux-mêmes dans le système auquel elles président, et donc devenir acentrées, comme lui. Evidemment, il y a nombre de barrières et d'écueils pour en arriver là. Si à première vue, les intérêts des lobbies semblent aller à l'encontre de la mise en place d'un Internet symétrique jusqu'à l'utilisateur même (ce qui conduit théoriquement à l'équivalence complète entre le "tuyau" d"une grande chaîne de télévision et de celui de Monsieur Tout le monde), nous sommes persuadés qu'après réflexion, les pouvoirs en question sont à même de comprendre que ce lâcher prise est un gage de survie pour eux-mêmes et pour l'économie mondiale. Mais pour qu'ils le comprennent, et que les opérateurs de télécommunication laissent effectivement passer les paquets Multicast, il va sans doute falloir le dire et le répéter plusieurs fois. Les Etats-Unis ne bougeront pas tant qu’ils tirent plus de profits du statu quo que du changement. La Chine est en avance dans le passage à l'IPv6, mais c'est uniquement pour disposer des adresses qui lui manquaient et pour affermir son contrôle. C’est sans doute dans les Etats européens, et singulièrement en France qui est dans une situation d’échec politique, économique et industriel absolu dans le monde de l’Internet actuel que peut apparaître la nécessité et la possibilité d'un véritable changement. Nous avons la conviction que ce changement ne pourra être obtenu par la seule force des acteurs qui se battent à l'intérieur des institutions de l'Internet version Ancien-Régime ou en confrontation directe avec celles-ci, quand bien même ils bénéficieraient d'une légitimité politique déléguée par les pouvoirs locaux. La résistance institutionnelle ne peut être fertile qu'à la condition qu'elle puisse s'adosser à la mise en œuvre massive par les utilisateurs eux-mêmes et dans un logique factuellement "bottom-up" de toutes les solutions exploitables aujourd'hui et allant dans la direction que nous avons rappelé, à savoir celle d'un Internet "symétrique", centré sur l'utilisateur, et réalisant un véritable espace public. Elles sont plus nombreuses que l'on pourrait le croire : d'une part, parce que l'ensemble de l'ancien système de gouvernance de l'Internet se fissure naturellement sous le poids du nombre croissant d'utilisateurs du réseau et, d'autre part, parce que, outre ces fissures, une foule de niches locales peuvent dès maintenant être occupées autrement. Nous en concluons à la nécessité de mettre en place sans plus attendre un dispositif massif permettant tout à la fois l'observation et le repérage des niches accessibles et la défense politique et juridique de tous ceux qui décideraient de les investir. Une organisation radicalement nouvelle, a été baptisée « Ψ.observer » à partir de la lettre grecque "psi" qui représente tout simplement l'acronyme de Personal Sustainable Internet (PSI), Internet Personnel et Durable. Son objet a été posé de telle manière qu'il puisse permettre à toute personne de revendiquer librement, sans autorisation ni déclaration préalable, une position d'observateur actif et de bénéficier du soutien de la communauté qui agira elle-même en tirant le maximum de profit de la puissance des organisations de pair à pair / peer to peer (P2P) qui s'imposent aujourd'hui comme le modèle d'avenir, démontré à travers de multiples exemples largement documentés notamment par la P2P Foundation [11]. [1] ICANN, IANA, IETF, W3C, ISOC, IGF, WSIS, UNESCO, SMSI, ONU, UIT, etc. Voir Carte de la Gouvernance de l'Internet établie par l'AFNIC http://www.afnic.fr/data/divers/public/afnic-dossier-gouvernance-internet-06-2008.pdf [2] Medusa: la structure hiérarchique de l'Internet. Cette visualisation de l’Internet donne une idée de la centralisation de l’Internet, mais la sous-estime car elle ne considère que les flux, et non pas les registres d’adresses qui forment une seule et même entité. http://www.adminet.info/Cawailleurs/archives/427/medusa-la-structure-hierarchique-de-linternet (3] RFC 2826: IAB Technical Comment on the Unique DNS Root Copyright (C) The Internet Society (2000). All Rights Reserved. http://tools.ietf.org/html/rfc2826 IANA (Internet Assigned Numbers Authority) http://www.iana.org/ [4] On a vu récemment comment NetworkSolutions, pour des bonnes ou de mauvaises raisons, en est venu à exercer une censure directe sur le film anti-islamiste de Geert Wilders : http://www.fitnathemovie.com/ Peine perdue évidemment puis que qu'il est disponible partout. [5] Cette conception est celle de la "Première cybernétique" construite à partir de 1942 par Arturo Rosenblueth, John von Neumann et Norbert Wiener, et beaucoup d'autres, s’attachant aux interactions entre « systèmes gouvernants » (ou systèmes de contrôle) et « systèmes gouvernés » (ou systèmes opérationnels), régis par des processus de rétroaction ou feed-back.. [6] En France, Nerim, Free, et OVH proposent depuis peu à leurs abonnés de passer à IPv6, mais il n'est pas certain à l'heure qu'il est que la possibilité du Multicast symétrique évoquée dans cet article soit effectivement possible et si les paquets Multicast sont routés effectivement au delà du backbone de ces opérateurs. Pour ceux qui connaissent: dans le cas de Free, c'est la transition IPv4&6 de Remi Dépres qui est implémentée. A voir quelles en sont les limites? [7] RFC 966 - Host groups: A multicast extension to the Internet Protocol S. E. Deering, D. R. Cheriton, Stanford University, December 1985. http://www.faqs.org/rfcs/rfc966.html Dans IPv4, la possibilité d'utiliser des adresses de groupe n'était qu'une verrue (extension) qui n'a été utilisée par les opérateurs que pour optimiser la bande passante sur leur réseau interne (backbone). C'est aussi ce qui a permis d'amener la télévision sur l'Internet et de proposer la réception de centaines de canaux aux abonnés de l'ADSL. Grâce au Multicast, les flux ne sont émis qu'une seule fois depuis les sources et ne sont routés jusqu'au destinataire que si celui-ci le demande. Il s'agit donc d'un protocole d'une grande économie, à tel point que depuis peu les gens d'Hollywood y voient l'avenir même de la télévision. C'est une vision commerciale fort étriquée des services que peut rendre Multicast. "The Once and Future King: Multicast looks to (finally) be the future of television." http://www.pbs.org/cringely/pulpit/2007/pulpit_20071221_003697.html [8] Il se trouve que ces logiciels existent, au moins au stade de prototypes, et que beaucoup d'entre eux ont été développé à la fin des années 90 à l'INRIA et à l' ENST Paris. http://www.infres.enst.fr/~dax/guides/multicast/mdownload.html En 94, Olivier Auber eu la chance de pouvoir impulser le développement de l'un des tout premiers logiciels Multicast ("gp" en bas de la liste) dont la version unicast se trouve là: http://perspective-numerique.net/wakka.php?wiki=GenerateurPoietique [9] Ces attendus théoriques sur le changement de paradigme dont est gros le passage à l'IPv6 figurent dans une étude publiée fin 2007 par l'Observatoire des Territoires Numériques (OTEN) à laquelle l'un d'entre nous a contribué (Olivier Auber) http://anoptique.org/PDF (Partie "cadrage théorique" de la page 11 à la page 37). Ce texte est également accessible sur wiki à l'adresse: http://perspective-numerique.net [10] Seconde cybernétique développée à partir de 1953 par Heinz von Foerster, puis par Ilya Prigogine, Humberto Maturana, Francisco Varela, etc. [11] The Foundation for P2P Alternatives : http://www.p2pfoundation.net

Après vous être enregistré ici sur ce wiki, cliquer là pour laisser un commentaire sur le texte GameOver

Commentaire de Olivier Auber

La première version de ce texte figure ici http://www.co-ment.net/text/274/ (avec les commentaires qui ont servi de base à la rédaction de la seconde version).

Michel Bauwens (P2P foundation)

http://blog.p2pfoundation.net/olivier-aubers-game-over-can-internet-governance-be-more-distributed/2008/04/01 In preparation of the June 2008 ICANN congress in Paris, our friend Olivier Auber (along with Olivier Zablocki) is hoping to start a debate and intervention against the increased re-centralization of the internet/web infrastructure, and particularly around the less than democratic current governance processes, see here for the text (in French). Olivier is hoping and calling for a vigorous debate about his intervention, so here is an initial commentary, in English. The text can be commented upon by paragraph. Michel Bauwens: It is important to distinguish between the computing infrastructure and what it enables; the centralized directory of the original Naptster still enabled people to peoplle filesharing; similarly, the hierarchical elements of the internet, and the client-server architecture of the Web, generally speaking still enable an enormous amount of permission-less communication, coordination and action. We have to keep this in mind, in order to correctly judge emancipatory possibilities. Centralized/decentralized features in systems that overall allow distributed action, can be ‘functional’ and actually useful to the efficiency of the system as a whole. At each stage, we have to think about whether the price of that efficiency is, or not, a weapon in the hands of those who would like to control the whole process. I’m saying this to avoid overkill. Indeed, saying that the internet as it know is is a essentially hierarchical system is a simplification. It contains hierarchical, decentralizede ( control powers competing with each other), and distributed (millions of people engaged in permissionless action without regard of the actual structure of the technology) elements, in a unstable configuration, with tendencies for more centralization competing with continued pushes for decentralization (by businesses and individual nation states) and distribution (by p2p sharing and commons communities as well as by individuals). If really it was a hierarchical system, that would mean there would be one boss commanding and controlling the whole social scene of the internet, and that is clearly not the case. In fact you admit this implicitely yourself by stating in the same first paragraph that each level of hierarchy is the subject of a struggle for legitimacy between different forces. So I would put it differently: 1) the internet is a system combining centralized/decentralized/distributed features which enables a significant amount of distributed action; 2) the technical organization of the internet however, is not distributed, but decentralized, the subject of power struggles by non-elected powers that do not represent the distributed user base, and with very weak mechanisms that would allow autonomous regulation by civil society in the current phase. This is therefore what we should fight for: to increase the mechanisms of distribution, and have both more direct governance at the level of usage, and more representative mechanisms wherever resource mobilization decisions are at play. Commentaires de Jean-Francois Morfin [BIO]

pas mal du tout

Si pour nous, utilisateurs de base de l'Internet, la gouvernance du réseau ressemble à une collusion entre organismes techniques, commerciaux et politiques [1] , c'est que contrairement à l'opinion couramment admise selon laquelle l'Internet serait un organisme acentré fonctionnant de manière répartie, il est au contraire parfaitement centralisé [2]. Le réseau est organisé de manière hiérarchique au niveau de ses normes et de son infrastructure. Au sommet de la pyramide il y a les 13 grands registres d’adresses dites « racines DNS » qui ne forment en fait qu’une seule et même entité [3]. > Au sommet de la pyramide il y a les fichiers IANA : le fichier des racines d'adressage IPv4 et IPv6 qui conditionnent la topologie du réseau, le fichier racine du nommage (noms de domaine) qui en conditionne l'utilisation telle qu'elle nous est prescrite, et maintenant les fichiers linguistiques se mettant en place pour la gestion de l'internationalisation des solutions ASCII, avec l'anglais comme langue pivôt.

> [Tout est un problème de pronciation française :

- e-commerce pour english inside commerce - i-commerce pour commerce intelligent] L'ICANN asssure l'intégrité de l'édifice au nom de l'intérêt général et des utilisateurs censés être au centre de tout. Dans les faits, ces utilisateurs ne sont jamais réellement partie prenante des discussions. Les grands groupes industriels et les Etats, autres que les Etats-Unis, font comme s'ils avaient voix au chapitre, mais c'est une illusion! En simplifiant à peine, à l'échelle mondiale, c'est le Département de la Défense américain et celui du Commerce qui ont le doigt sur le bouton ON/OFF du réseau, via des instances qu'ils contrôlent plus ou moins directement et divers avatars commerciaux, tels Google qui n'en finit pas de rafler toutes les données mondiales en même temps qu'une part toujours plus grande des cerveaux, des capitaux et des recettes publicitaires. S'il en est ainsi, ce n'est pas le fait d'un quelconque complot. C'est la conséquence de l'architecture historique de l’Internet qui > n'a jamais été construit pour cela et qui ne s'est développé que comme porteur de la dérégulation américaine des télé/datacommunications dans un monde où l'Europe continentale n'a pas su réagir, trouvant une excuse à sa bureacratie dans une prétendu supériorité technologique américaine, et où le reste du monde n'avait pas les moyens de réagir.

dès sa création a dessiné un monde où l'Europe et le reste du monde avaient déjà perdu. Les organes centraux américains ont toujours pris logiquement les décisions qu'il fallait pour renforcer leur position dominante et toutes les structures intermédiaires n'ont jamais rien fait d'autre que de se disputer les miettes (marchés locaux). > Dans ce contexte l'énorme avance technico-sociétale du Minitel français, l'avance commerciale de la dérégulation anglaise, se sont trouvées submergées par un bricolage américain que les gens ont pris comme une chute du mur de Berlin du monopole des télécommunications, et le Global Internet comme les GI d'un nouveau débarquement de Normandie.

> Trente-cinq ans aprés sa conception comme le "réseau [distribué] DES RESAUX' par Louis Pouzin, vingt-cinq ans aprés sa création à partir d'ARPANET comme "LE RESEAU [central] des réseaux" ...

Trente ans après sa création, le "réseau des réseaux" a produit des concentrations capitalistiques sans précédent, cristalisées dans des infrastructures (backbones et serveurs DNS), des normes (protocoles d'échange, etc.), des codes (logiciels) et pour finir dans une langue dominante (l'anglais). La situation de monopole est le rêve du capitalisme, jusqu'à une certain point. Aujourdhui, le grand méchant loup, voyant qu’il a dévoré tous les agneaux, commence à s'apercevoir qu'ils n'aura bientôt plus rien à se mettre sous la dent. Surtout les petits prédateurs voient qu'ils se retrouveront bientôt sans proies. Si rien ne change, le capitalisme se sera tiré une balle dans le pied: GAME OVER. Dans ce contexte de domination absolue, quelles chances a encore une quelconque pluralité linguistique et culturelle de s'imposer? A notre avis aucune, si on se contente de jouer suivant les règles du jeu actuelles. > oubliant les principes consensuels du Sommet Mondial de la Société de l'Information, face au bluff du politico-techniquement unique de la pensée dominante (ICANN, IETF, IAB, ISOC). A travers eux l'industrie et l'Etats dominant joue le forcing pour imposer pour longtemps dans les faits politiques et commerciaux ce qu'ils ont théoriquement concédé faute des technologies nécessaires : un parapluie numérique et informationnel mondial américain. RFC 3935 : la mission de l'IETF est d'influencer la manière dont est développé, utilisé et géré l'Internet pour qu'il marche mieux à travers le monde en étudiant et documentant en anglais non pas la technologie qui pourrait être, mais celle qui correspond aux valeurs de l'IETF (décentralisation, couche présentation unique, réseau-centré, pas d'intelligence au coeur du réseau).

Les organismes internationaux qui portent ce type de revendications (UNESCO, SMSI,... > UIT, ISO, etc. ) sont intrinséquement inadaptés face à la position unilatérale américaine, faute d'avoir encore assimilé les principes de gouvernance mondiale qu'ils ont su reconnaitre : principes de souveraineté, proportionalité, subsidiarité concertés entre le domaine régalien, la société civile, le secteur privé, les organisations internationales et le monde technique et normatif qui constriut la virtualité du monde où nous vivons sans aucun contrôle reprsentatif.

> Les entreprises sont à la remorque. La société civile est intrinsèqment dvisiée, ...

... ISOC, @Large, etc.) sont intrinsèquement divisés, en proie à des conflits de légitimité sans fin. Ils ont recours en dernier ressort aux Etats dont les modalités démocratiques sont disparates, sujettes à caution, et archaïques en regard des usages de l'Internet. Après le 11 septembre 2001, les Etats Unis sont devenus les principaux artisans du "tout sécuritaire" qui entraîne lui-même la défiance et le terrorisme que leur sécurité prétend combattre... > pour eux et pour le reste d'un monde très peu conscients des risques nés des technologies nouvelles dont il dépend pourtant de plus en plus au quotidien (100% de l'économie américaine, 80% de l'économie européenne).

La maigre souveraineté qu'ils tentent d'obtenir sur des zones linguistiques, géographiques et culturelles du réseau n'apparait pas aux simples utilisateurs que nous sommes comme une planche de salut. > face à l'industrie du "shaping the world" (Donald Rumsfeld)

Bien au contraire, nous la vivons comme un niveau de verrouillage supplémentaire reproduisant à une échelle plus réduite celui qui est à l'oeuvre à l'échelle mondiale. Le cas de la Chine est l'emblème > d'une résistance technique possible, mais elle reste timorée et un facteur de fractionnement probable (balkanisation du réseau) car principalement liée à un souci de protection de l'influence politique occidentale.

de cette dérive, mais les pays européens ne sont pas en reste (pénalisation du P2P, généralisation de la surveillance du réseau via les serveurs DNS locaux, etc.). > surveillance des traffics, abandon de la protection du DNS dont les serveurs devraient être locaux par mesure de sécurité et de confidentialité des données économiques et stratégiques.

Ils n'apparaissent en rien comme des barrières au contrôle et à l'uniformisation des esprits. Pire, ils agissent en défenseurs des lobbies et en représentants de commerce de "l'Internet haut débit". Mais nous ne voulons pas de cet Internet là qui livre les citoyens pieds et poings liés à des grands groupes! Bref, sur le plan linguistique et culturel aussi, nous sommes au bord de la déréliction complète. GAME OVER. Entendons-nous bien: il ne s'agit pas de faire ici le procès des personnes impliquées dans les organismes cités plus haut, ni même de mettre en doute leur engagement et leur sincérité. Nous constatons simplement qu'ils fabriquent collectivement et à grand frais un monde dans lequel chacun d'entre-eux, à titre individuel, ne voudrait vivre.Tous sont finalement des victimes d'un phénomène systémique, à la racine duquel se trouve selon nous l'architecture actuelle de l'Internet héritée d'une conception ancienne et dépassée de la cybernétique [5]. > héritée par hasard du succès pratique d'une conception prototype ancienne et dépassée des réseaux que sa sur-simplification rendait attractive face à la bureaucratie des monopoles. La bonne gestion d'une solution cybernétiquement inadéquate l'a emportée sur la rigidté de la gestion de la bonne technologie.

Alors où est la sortie? Et bien peut-être dans l'exploration d'une nouvelle architecture du réseau. Il est dit partout que la version actuelle du protocole sur lequel fonctionne l'Internet depuis 25 ans arrivera à saturation vers 2011 et qu'en conséquence le passage à sa version 6 (IPv6) devra avoir lieu avant, c'est-à-dire tout de suite [6]. > En fait il s'agit essentiellement de passer de 4 à 8 chiffres (avec 8 chiffres de plus pour la partie privée). Rien de bien excitant techniquement, voté depuis 1983, et beaucoup, beaucoup de problèmes en perspective.

Beaucoup n' y voient qu'un un saut quantitatif, donc à savoir que les nouvelles adresses disponibles à profusion (2 puissance 128, soit environ 2,56 × 10 puissance 38) pourront être utilisées pour identifier, relier et contrôler n'importe quoi (qui), ce qui peut être la source de nouveaux profits ; jusque là, rien de nouveau sur le fond. Mais il y a dans IPv6 l'amorce d'un changement qualitatif

> psychologique né de l'espoir qu'il y quelque chose de nouveau, on ne sait pas quoi et donc on espère beaucoup, suscitant par là des attentes qui sont de nouveaux marchés et espace de développement. L'un d'entre-eux qui est très mal exploité actuellement, en raison de sa complexité technique et de la complexité encore plus grande que serait sa limitation, peut avoir une conséquence conceptuellement décisive.

qui, selon nous, a une importance décisive: c'est la notion d'adressage de groupe connue sous le nom de "IP Multicast" définie par Steve Deering [7] dès 1985. Dans l’Internet tel que nous le connaissons, il est impossible de réunir un « groupe » - ce terme désignant une assemblée en conversation synchrone ou asynchrone comprenant plus de deux personnes, ce qui peut vouloir dire des millions - sans avoir recourt à une machine particulière effectuant > un système de machines particulier centralisant (aliénant) logiquement la communication entre des individus

la commutation entre les individus.

> qui sont dans la vie librement distribués et indépendants.

Cette machine dépend nécessairement d’un tiers extérieur au groupe (Facebook par exemple), c'est à dire que l'on est toujours "chez quelqu'un" lorsque l'on croit être dans une simple conversation avec autrui dans l'espace public. Il faut donc le dire et le répéter : à ce jour, il n'existe pas de véritable espace public sur l'Internet ! Dans le contexte de verrouillage commercial et sécuritaire du réseau auquel nous assistons, cela équivaut de plus en plus à une « interdiction de réunion sur la voie publique » puisque cette voie publique n'existe pas, en tous cas à une surveillance automatique des réunions privées. Les « adresses de groupe » prévues dans la prochaine version de l’Internet font potentiellement sauter ce verrou. Elles ne sont pas attachées à une machine particulière. A ce jour, elles ne sont pas la propriété de qui que ce soit, et peuvent être choisies et utilisées par n’importe qui. Tel que défini par Steve Deering, le protocole Multicast est symétrique, c'est à dire qu'il est théoriquement possible pour tous de recevoir ET d'émettre un flux de quelque nature que ce soit sous couvert d'un numéro de groupe. Bien entendu, il faut pour cela des logiciels particuliers [8] capables de formater et d'interpréter ces données. Dès lors, il est possible avec le Multicast de faire de manière économique et sans dépendre de tiers, beaucoup de choses que l'ont fait déjà avec l'Internet actuel (dit Unicast), mais il est surtout envisageable de concevoir une toute nouvelle classe d'applications collaboratives distribuées qui pourraient rendre désuètes très rapidement celles du Web 2.0. Il y a donc en germe dans IPv6 une toute nouvelle culture du réseau, voire un changement de paradigme qui pourrait remettre le compteur à zéro, à tout le moins rebattre les cartes entre les Etats-Unis et le reste du monde. Ipv6 peut contribuer à créer enfin un véritable espace public sur l'Internet, à condition que cette idée soit défendue. Ce changement, nous l’analysons comme le passage d’un réseau fonctionnant suivant une forme de « perspective temporelle » admettant comme points de fuite les serveurs assurant la commutation des groupes, à un autre où s’exercerait une « perspective numérique » [9] régulée par des « codes de fuite » que sont les addresses IP de groupe. Cette transformation extrêmement profonde pourraient conduire l'actuelle "économie de l'attention" a muter en une "économie du lien" impliquant de tout autres rapports sociaux. Elle induit au passage un renouveau complet des formes de légitimité des structures présidant aux destinées du réseau. Dans un esprit plus proche de la « seconde cybernétique » [10], ces organismes devront s’inclure eux-mêmes dans le système auquel elles président , et donc devenir acentrées, comme lui. Evidemment, il y a nombre de barrières et d'écueils pour en arriver là. Si à première vue, les intérêts des lobbies semblent aller à l'encontre de la mise en place d'un Internet symétrique jusqu'à l'utilisateur même (ce qui conduit théoriquement à l'équivalence complète entre le "tuyau" d"une grande chaîne de télévision et de celui Monsieur-Tout-le-monde), nous sommes persuadé qu'après réflexion, les pouvoirs en question sont à même de comprendre que ce lâcher prise est un gage de survie pour eux-mêmes et pour l'économie mondiale. Mais pour qu'ils le comprennent, et que les opérateurs de télécommunication laissent effectivement passer les paquets Multicast, il va sans doute falloir le dire et le répéter plusieurs fois. Les Etats-Unis ne bougeront pas tant qu’ils tirent plus de profits du statu quo que du changement. La Chine est en avance dans le passage à l'IPv6, mais c'est uniquement pour disposer des adresses qui lui manquaient et pour affermir son contrôle. C’est sans doute dans les Etats européens, et singulièrement en France qui est dans une situation d’échec politique, économique et industriel absolu > relatif dans l'absolu, mais absolu et affligeant par rapport à l'avance qui devrait historiquement être la sienne dans le monde de l’Internet actuel que peut apparaître la nécessité et la possibilité d'un véritable changement.

Nous avons la conviction que ce changement ne pourra > pourrait

être obtenu par la seule force des acteurs qui se battent à l'intérieur des institutions de l'Internet version Ancien-Régime ou en confrontation directe avec celles-ci, quand bien même ils bénéficieraient d'une légitimité politique déléguée par les pouvoirs locaux. > Cette résistance institutionnelle et des "@large" (utlisateurs pilotes, co-développeurs de l'Internet) permet de protéger l'avenir contre certains choix absurdes à court terme commercial.

> Dans le contexte de la nouvelle gouvernance du monde dont participe l'internet, elle est capable, en s'adossant sur chacun des cinq pôles de la gouvernance de trouver les bonnes réponses et de les propager viralement pour un internet "symétrique", centré sur la personne et pas seulement sur l'utilisateur de la technologie ambiante.

La résistance institutionnelle ne peut être fertile qu'à la condition qu'elle puisse s'adosser à la mise en œuvre massive par les utilisateurs eux-mêmes et dans un logique factuellement "bottom-up" de toutes les solutions exploitables aujourd'hui et allant dans la direction que nous avons rappelé, à savoir celle d'un Internet "symétrique", centré sur l'utilisateur, et réalisant un véritable espace public. Elles sont plus nombreuses que l'on pourrait le croire : d'une part, parce que l'ensemble de l'ancien système de gouvernance de l'Internet se fissure naturellement sous le poids du nombre croissant d'utilisateurs du réseau et, d'autre part, parce que, outre ces fissures, une foule de niches locales peuvent dès maintenant être occupées autrement. > Nous somme en particulier à un moment de rencontre entre la convergence numérique et l'émergence sémantique qui font déborder les problèmes et les réponses du seul domaine de l'Internet pour les amener vers ce que l'on pourrait appeler le "psy to psy" - le tête à tête, aprés le prise à prise du signal et le bout en bout du contenu. Commentaires de Philippe Vacheyrout http://www.capucine.net/article.php?id_article=15 Capucine c'est une plante grimpante C'est aussi un label de bon usage des TICs pour le développment durable http://www.capucine.net et un réseau de confiance numérique http://www.capucine.eu Pour contribuer à la Gouvernance (Alliance) de l'Internet http://alfrance.info/index.php?title=Capucine GameOverEngl

Il n'y a pas de commentaire sur cette page.

[Afficher commentaires/formulaire]

|